主题

DeepSeek-R1 1.5B模型安装到手机上

1. 准备环境

- 手机要求:确保手机有足够的存储空间和内存(建议至少4GB RAM)。

- 操作系统:Android或iOS均可,但Android更灵活。

- 工具:Termux(Android)或iSH(iOS)用于命令行操作。

2. 安装Termux(Android)或iSH(iOS)

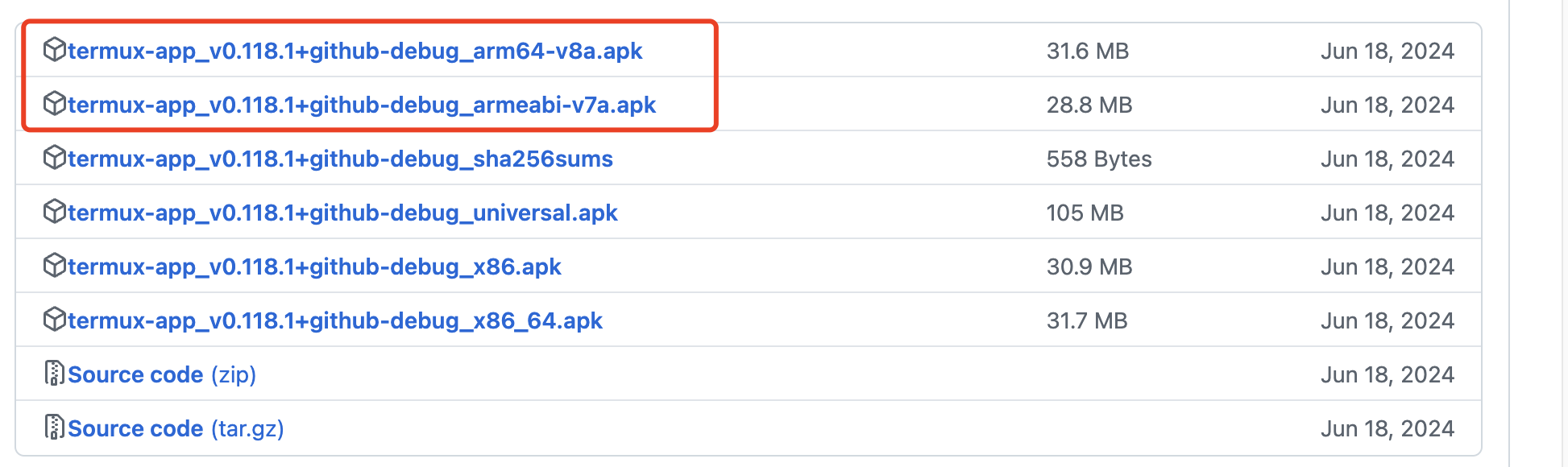

下载Termux

https://github.com/termux/termux-app/releases/tag/v0.118.1

armeabi-v7a表示32位ARM架构,而arm64-v8a表示64位ARM架构

查看手机的cpu架构

shell

adb shell getprop ro.product.cpu.abi比如

shell

arm64-v8a3. 安装Python和相关依赖

- 打开Termux或iSH,运行以下命令:bash

pkg update pkg install python pkg install openssl ca-certificates wget -y pip install torch transformers

本地化安装 torch

https://pypi.tuna.tsinghua.edu.cn/simple/torch/

shell

wget https://pypi.tuna.tsinghua.edu.cn/packages/49/0c/46ffc4377156b1126c1bec9e177e16bb0410b592c5391e690486b21e4f62/torch-2.2.0-cp312-cp312-manylinux2014_aarch64.whl#sha256=9eeb42971619e24392c9088b5b6d387d896e267889d41d267b1fec334f5227c5torch文件的含义

torch-{版本}-{Python 版本}-{ABI 标签}-{平台标签}.whl

shell

~ $ uname -m

aarch644. 下载DeepSeek-R1 1.5B模型

- 使用

transformers库下载模型:pythonfrom transformers import AutoModelForCausalLM, AutoTokenizer model = AutoModelForCausalLM.from_pretrained("deepseek-ai/deepseek-r1-5b") tokenizer = AutoTokenizer.from_pretrained("deepseek-ai/deepseek-r1-5b")

5. 优化模型

- 由于手机资源有限,建议对模型进行量化或剪枝:python

from torch.quantization import quantize_dynamic model = quantize_dynamic(model, {torch.nn.Linear}, dtype=torch.qint8)

6. 运行模型

- 编写一个简单的Python脚本来加载并运行模型:python

input_text = "你好,DeepSeek-R1 1.5B" inputs = tokenizer(input_text, return_tensors="pt") outputs = model.generate(**inputs) print(tokenizer.decode(outputs[0], skip_special_tokens=True))

7. 测试与优化

- 运行脚本,观察性能并根据需要进行进一步优化。

注意事项

- 性能:手机性能可能限制模型运行速度。

- 存储:模型文件较大,确保有足够存储空间。

- 电池:长时间运行可能消耗较多电量。